Tag: SEO

Mitte der 1990er Jahre fingen die anfänglichen Suchmaschinen im Internet an, das frühe Web zu katalogisieren. Die Seitenbesitzer erkannten rasch den Wert einer lieblings Listung in den Ergebnissen und recht bald entwickelten sich Anstalt, die sich auf die Aufbesserung spezialisierten.

In Anfängen geschah die Aufnahme oft zu der Transfer der URL der entsprechenden Seite in puncto vielfältigen Internet Suchmaschinen. Diese sendeten dann einen Webcrawler zur Prüfung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Homepage auf den Webserver der Suchmaschine, wo ein weiteres Anwendung, der gern genutzte Indexer, Informationen herauslas und katalogisierte (genannte Wörter, Links zu anderen Seiten).

Die neuzeitlichen Typen der Suchalgorithmen basierten auf Angaben, die anhand der Webmaster eigenhändig vorgegeben werden konnten, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im WWW wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht per Content einer Seite, allerdings setzte sich bald hervor, dass die Benutzung dieser Vorschläge nicht zuverlässig war, da die Wahl der genutzten Schlüsselworte dank dem Webmaster eine ungenaue Präsentation des Seiteninhalts sonstige Verben kann. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Internetseiten bei individuellen Suchen listen.[2] Auch versuchten Seitenersteller diverse Merkmale innerhalb des HTML-Codes einer Seite so zu lenken, dass die Seite überlegen in Resultaten gelistet wird.[3]

Da die frühen Suchmaschinen im Internet sehr auf Kriterien abhängig waren, die ausschließlich in den Koffern der Webmaster lagen, waren sie auch sehr anfällig für Delikt und Manipulationen im Ranking. Um überlegenere und relevantere Urteile in Serps zu bekommen, mussten sich die Anbieter der Suchmaschinen im WWW an diese Rahmenbedingungen integrieren. Weil der Gewinn einer Anlaufstelle davon abhängig ist, wichtige Suchresultate zu den inszenierten Keywords anzuzeigen, konnten ungünstige Testurteile darin resultieren, dass sich die Benützer nach ähnlichen Wege für die Suche im Web umsehen. Die Antwort der Suchmaschinen im Internet inventar in komplexeren Algorithmen fürs Ranking, die Kriterien beinhalteten, die von Webmastern nicht oder nur schwierig kontrollierbar waren. Larry Page und Sergey Brin entworfenen mit „Backrub“ – dem Urahn von Suchmaschinen – eine Search Engine, die auf einem mathematischen Suchalgorithmus basierte, der anhand der Verlinkungsstruktur Seiten gewichtete und dies in den Rankingalgorithmus einfluss besitzen ließ. Auch sonstige Suchmaschinen orientiert zu Gesprächsaufhänger der Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein.

Yahoo

Danny Search engine marketing Teaches You Methods to Make the Good Present Out of Wine Corks | Do Just One Thing

On-page SEO Tutorial – Rank Any Website or Weblog on 1st Web page of Google in 2020 | Pritam Nagrale

Nachricht: Find out how to Make the search engine optimisation Case to Small Businesses – Whiteboard Friday

Mehr zu: Danny Website positioning Teaches Drew Tips on how to Make Scrumptious No-Bake Vegan Cheesecake

Mitteilung: The right way to SEO eBay Product Title for improve gross sales? Full tutorial – create distinctive Product Title | 2021

Nachricht: Off Page SEO Tutorial for Freshmen | Off Page search engine optimization Full Course in Hindi | Off Page SEO Kaise Kare

![How To Rank No. 1 On youtube | {Learn|Study|Be taught} Youtube {SEO|search engine optimization|web optimization|search engine marketing|search engine optimisation|website positioning} Step by Step Tutorial [SEO] How To Rank No. 1 On youtube | {Learn|Study|Be taught} Youtube {SEO|search engine optimization|web optimization|search engine marketing|search engine optimisation|website positioning} Step by Step Tutorial [SEO]](/wp-content/uploads/2022/06/1654246279_maxresdefault.jpg)

How To Rank No. 1 On youtube | Be taught Youtube search engine optimisation Step by Step Tutorial [SEO]

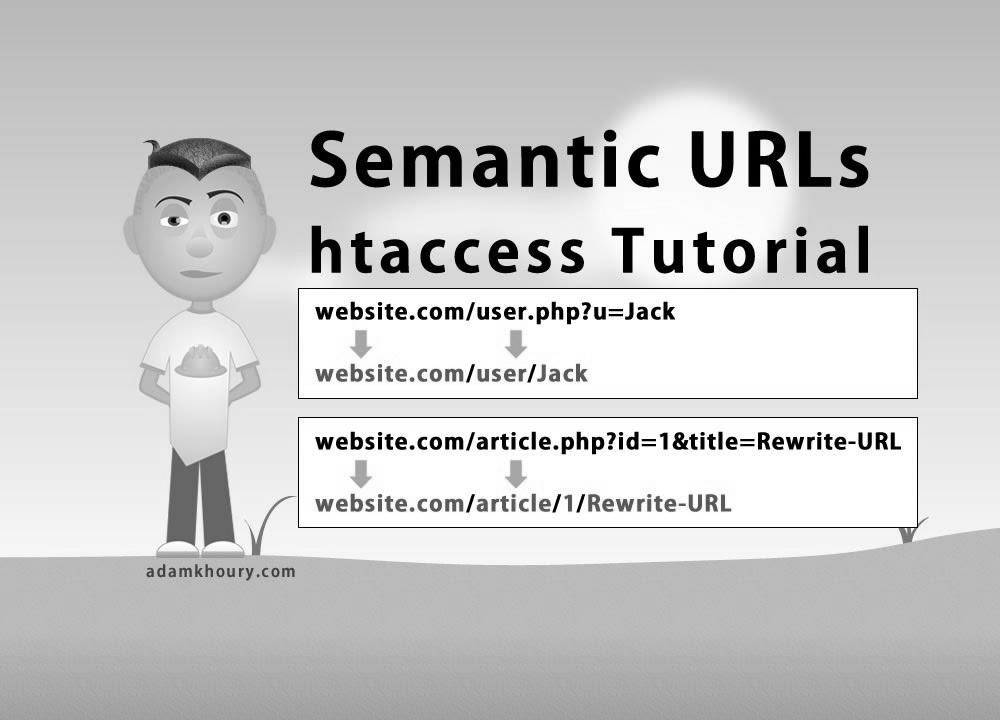

Semantic URL htaccess Tutorial Search engine marketing Friendly Clean Links Rewrite

How To: Managing Property and SEO – Be taught Next.js